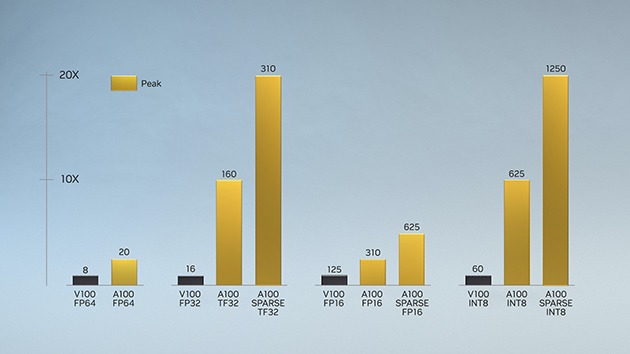

Mit der ersten Einführung in der NVIDIA Volta™-Architektur hat die NVIDIA Tensor Recheneinheit-Technologie KI drastisch beschleunigt, wodurch die Trainingszeiten von mehreren Wochen auf wenige Stunden gesenkt und die Inferenz massiv beschleunigt wurde. Die NVIDIA Ampere-Architektur baut auf diesen Innovationen auf und ermöglicht neue Präzisionsniveaus – Tensor Float (TF32) und Gleitkomma 64 (FP64) –, um die KI-Akzeptanz zu beschleunigen und zu vereinfachen und die Leistung von Tensor-Recheneinheiten auf HPC auszudehnen.

TF32 funktioniert genau wie FP32 und liefert bis zu 20-mal mehr Leistung für KI, ohne dass Codeänderungen erforderlich sind. Mit Nvidia Automatic Mixed Precision können Forscher mit automatischer Mixed-Precision und FP16 eine zusätzliche 2-fache Leistung erzielen, indem sie nur ein paar Codezeilen hinzufügen. Mit der Unterstützung von bfloat16, INT8 und INT4 sind die Tensor-Recheneinheiten in den NVIDIA Ampere-Architektur Tensor Core Grafikprozessoren ein unglaublich vielseitiger Beschleuniger für KI-Training und Inferenz. Mit der Leistung von Tensor-Recheneinheiten für HPC ermöglichen die A100- und A30-Grafikprozessoren auch Matrixoperationen in vollständiger, IEEE-zertifizierter FP64-Präzision.