Bestärkendes Lernen

Roboterlerntechnik zur Entwicklung anpassungsfähiger und effizienter Roboteranwendungen.

Nissan

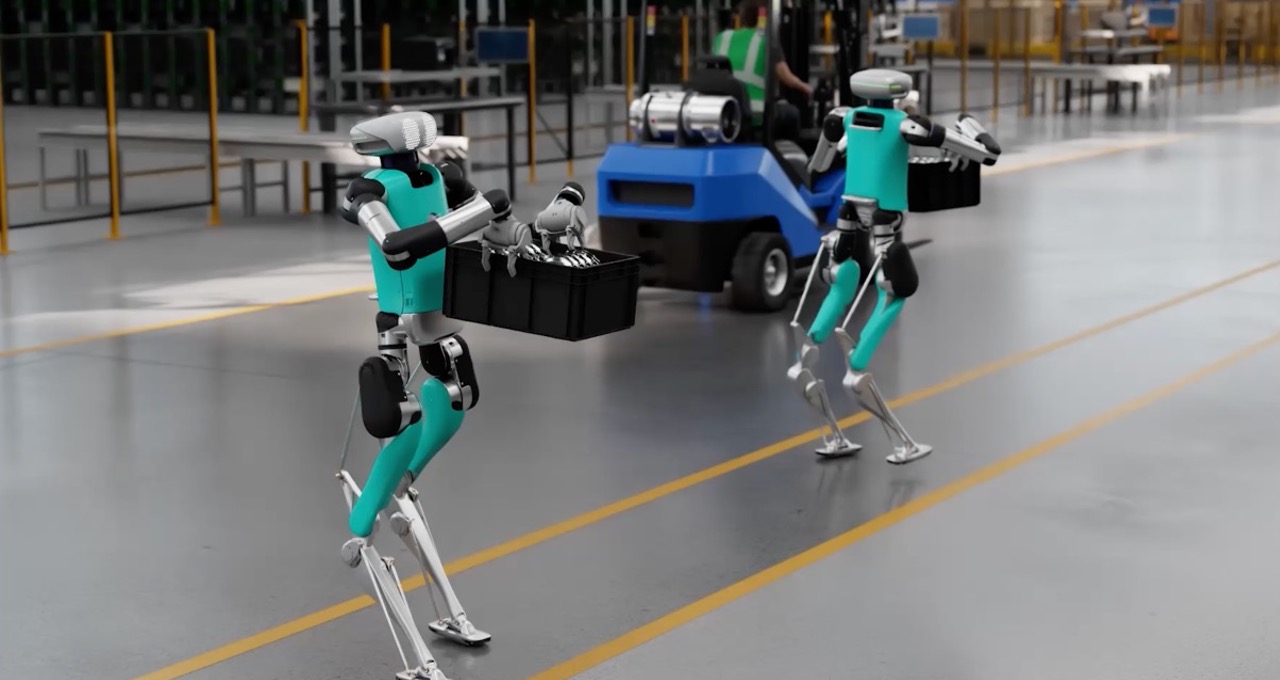

Image Credit: Agility, Apptronik, Fourier Intelligence, Unitree

Workloads

Robotik

Branchen

Alle Branchen

Geschäftsziel

Innovation

Produkte

NVIDIA Omniverse

NVIDIA Omniverse Enterprise

NVIDIA AI Enterprise

-

Überblick

-

Technische Umsetzung

-

Partnernetzwerk

Ermächtigen Sie physische Roboter mit komplexen Fähigkeiten mithilfe von bestärkendem Lernen

Da Roboter komplexere Aufgaben übernehmen, reichen die traditionellen Programmiermethoden nicht mehr aus. Bestärkendes Lernen (Reinforcement Learning, RL) ist eine Technik des maschinellen Lernens, die entwickelt wurde, um diese Herausforderung durch die Programmierung des Roboterverhaltens zu bewältigen. Mit RL in der Simulation können Roboter in jeder virtuellen Umgebung durch Versuch und Irrtum trainieren und so ihre Fähigkeiten in den Bereichen Steuerung, Pfadplanung, Manipulation und mehr verbessern.

Das RL-Modell wird für gewünschte Aktionen belohnt, daher wird es ständig angepasst und verbessert. Dies hilft Robotern, anspruchsvolle grob- und feinmotorische Fähigkeiten zu entwickeln, die für reale Automatisierungsaufgaben wie das Greifen neuer Objekte, das vierbeinige Gehen und das Erlernen komplexer Manipulationsfähigkeiten erforderlich sind.

Durch die kontinuierliche Verfeinerung der Kontrollrichtlinien basierend auf Belohnungen und der Analyse ihrer Aktionen kann RL Robotern auch dabei helfen, sich an neue Situationen und unvorhergesehene Herausforderungen anzupassen, wodurch sie anpassungsfähiger für Aufgaben in der realen Welt werden.

GPU-beschleunigte RL-Training für Robotik

Traditionelles CPU-basiertes Training für Roboter-RL kann teuer sein, da oft Tausende von Rechenkernen für komplexe Aufgaben benötigt werden, was die Kosten für Roboteranwendungen in die Höhe treibt. NVIDIA-GPUs lösen diese Herausforderung mit ihren parallelen Verarbeitungsfunktionen und beschleunigen die Verarbeitung sensorischer Daten in wahrnehmungsbasierten Umgebungen des bestärkenden Lernens erheblich. Dadurch werden die Fähigkeiten von Robotern, zu lernen, sich anzupassen und komplexe Aufgaben in dynamischen Umgebungen auszuführen, erheblich verbessert.

Die Rechenplattformen von NVIDIA – einschließlich Tools wie Isaac Lab – nutzen die GPU-Leistung sowohl für Physiksimulationen als auch für Belohnungsermittlungen innerhalb der RL-Pipeline. Dies beseitigt Engpässe und rationalisiert den Prozess, wodurch ein reibungsloserer Übergang von der Simulation zur realen Bereitstellung ermöglicht wird.

Quick-Links