Aprendizaje de refuerzo

Técnica de aprendizaje robótico para desarrollar aplicaciones robóticas adaptables y eficientes.

Nissan

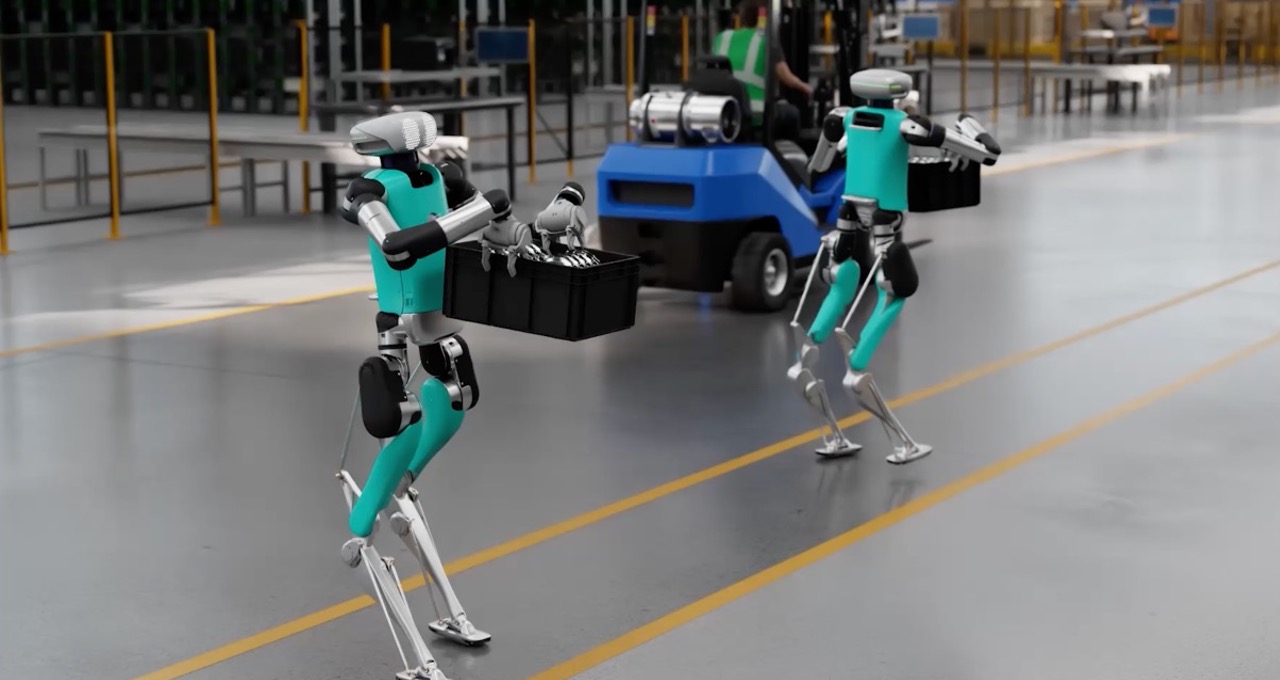

Image Credit: Agility, Apptronik, Fourier Intelligence, Unitree

Cargas de trabajo

Robótica

Sectores

Todos los sectores

Objetivo del negocio

Innovación

Productos

NVIDIA Omniverse

NVIDIA Omniverse Enterprise

NVIDIA AI Enterprise

-

Descripción

-

Implementación técnica

-

Ecosistema de socios

Potenciar robots físicos con habilidades complejas usando el aprendizaje por refuerzo

A medida que los robots asumen tareas más complejas, los métodos de programación tradicionales se vuelven insuficientes. El aprendizaje por refuerzo (RL, por sus siglas en inglés) es una técnica de aprendizaje automático diseñada para abordar este desafío mediante la programación del comportamiento del robot. Con el aprendizaje por refuerzo (RL, por sus siglas en inglés) en simulación, los robots se pueden entrenar en cualquier entorno virtual a través de prueba y error, mejorando sus habilidades en control, planificación de rutas, manipulación y mucho más.

El modelo de RL es recompensado por las acciones deseadas, por lo que se adapta y mejora constantemente. Esto ayuda a los robots a desarrollar habilidades motoras finas y gruesas necesarias para tareas de automatización del mundo real, como agarrar objetos novedosos, caminar a cuatro patas y aprender habilidades de manipulación complejas.

Al perfeccionar continuamente las políticas de control basadas en las recompensas y analizar sus acciones, el RL también puede ayudar a los robots a adaptarse a nuevas situaciones y desafíos imprevistos, haciéndolos más versátiles para tareas del mundo real.

Entrenamiento de RL para robótica acelerado por GPU

El entrenamiento tradicional basado en CPU para RL de robots puede ser costoso, a menudo requiere miles de núcleos para tareas complejas que aumentan los costes de las aplicaciones de robots. Las GPU de NVIDIA abordan este desafío con sus capacidades de procesamiento paralelo y aceleran significativamente el procesamiento de datos sensoriales en entornos de aprendizaje por refuerzo habilitados para la percepción. Esto mejora significativamente las capacidades de los robots para aprender, adaptarse y realizar tareas complejas en entornos dinámicos.

Las plataformas de computación de NVIDIA, que incluyen herramientas como Isaac Lab, aprovechan la potencia de la GPU para realizar simulaciones físicas y cálculos de recompensa dentro de los procesos del RL. Esto elimina los cuellos de botella y agiliza el proceso, facilitando una transición más suave de la simulación a la implementación real.

Enlaces rápidos