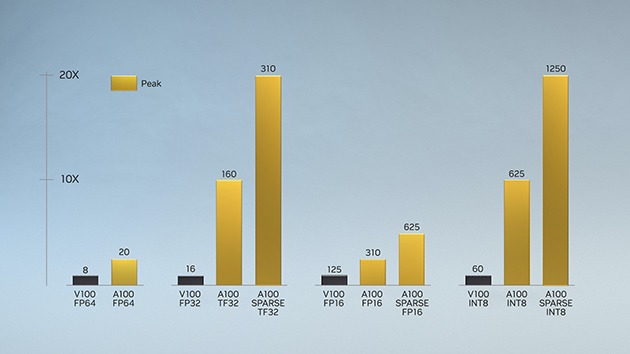

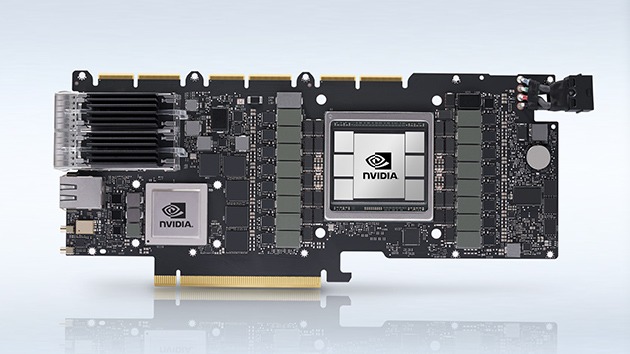

Introducida por primera vez en la arquitectura NVIDIA Volta™, la tecnología NVIDIA Tensor Core ha traído drásticas aceleraciones a la IA, reduciendo los tiempos de entrenamiento de semanas a horas y proporcionando una enorme aceleración a la inferencia. La arquitectura NVIDIA Ampere se basa en estas innovaciones al brindar nuevas precisiones, Tensor Float 32 (TF32) y punto flotante 64 (FP64), para acelerar y simplificar la adopción de IA y extender el poder de Tensor Cores a HPC.

TF32 funciona igual que FP32 mientras ofrece aceleraciones de hasta 20 veces para AI sin requerir ningún cambio de código. Con NVIDIA Automatic Mixed Precision, los investigadores pueden obtener un rendimiento 2 veces adicional con precisión mixta automática y FP16 agregando solo un par de líneas de código. Y con soporte para bfloat16, INT8 e INT4, Tensor Cores en la arquitectura NVIDIA Ampere, las GPU Tensor Core crean un acelerador increíblemente versátil tanto para el entrenamiento de IA como para la inferencia. Llevar la potencia de Tensor Cores a las GPU HPC, A100 y A30 también permite operaciones matriciales con total precisión FP64 con certificación IEEE.