Entrenamiento de ResNet-50, conjunto de datos: ImageNet2012, BS=256 | Comparación de NVIDIA V100: Servidor NVIDIA DGX-2™, 1 V100 SXM3-32GB, MXNet 1.5.1, contenedor = 19.11-py3, precisión mixta, productividad: 1525 imágenes/s | Comparación de Intel: Supermicro SYS-1029GQ-TRT, 1 socket Intel Gold 6240 a 2 Ghz/3,9 Hz Turbo, Tensorflow 0.18, FP32 (una sola precisión disponible), productividad: 48 imágenes/s

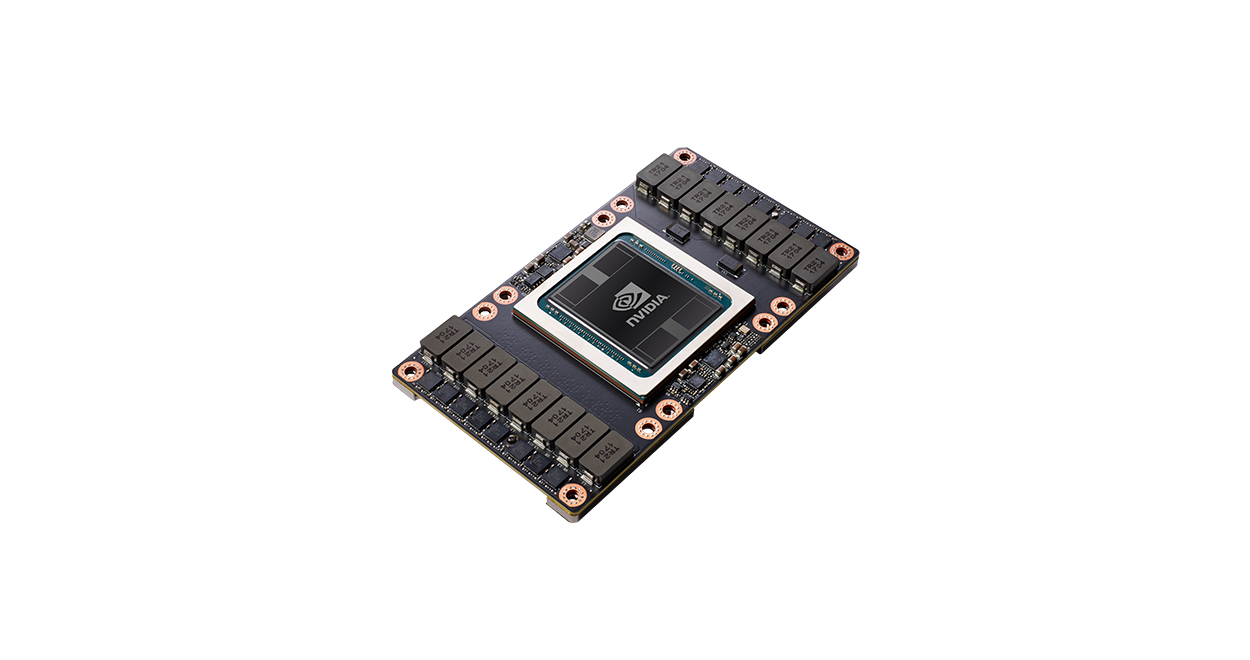

GPU NVIDIA V100 CON NÚCLEOS TENSOR

La Primera GPU con Núcleos Tensor