Desde reconocer el habla hasta capacitar a asistentes personales virtuales y enseñar a conducir automóviles autónomos, los científicos de datos están asumiendo desafíos cada vez más complejos con la inteligencia artificial. Resolver este tipo de problemas requiere entrenar modelos de deep learning que están creciendo exponencialmente en complejidad, en una cantidad de tiempo práctica.

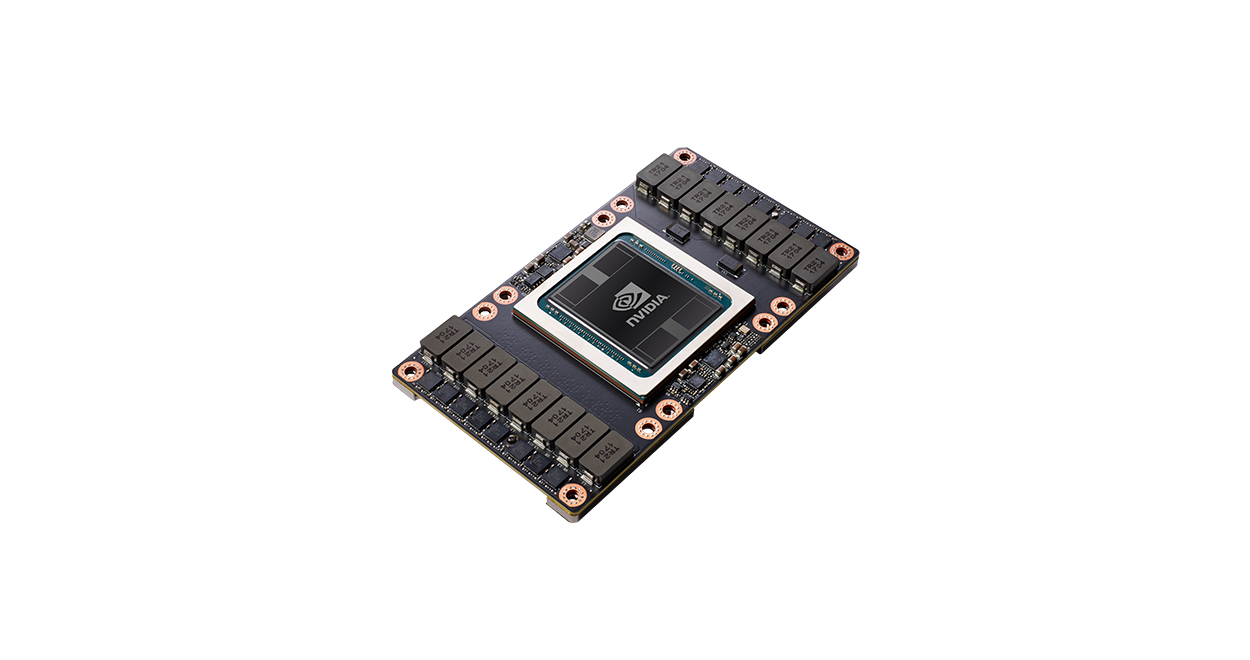

Con 640 Tensor Cores, V100 es la primera GPU del mundo que rompe la barrera de los 100 teraFLOPS (TFLOPS) del rendimiento del aprendizaje profundo. La próxima generación de NVIDIA NVLink™ conecta varias GPU V100 de hasta 300 GB / s para crear los servidores informáticos más potentes del mundo. Los modelos de IA que consumirían semanas de recursos informáticos en sistemas anteriores ahora se pueden entrenar en unos pocos días. Con esta drástica reducción en el tiempo de entrenamiento, ahora se podrá resolver un nuevo mundo de problemas con la IA.