Le registre de conteneurs NGC comprend les meilleurs logiciels tirant profit de l’accélération GPU pour la science des données, l’apprentissage automatique et l’analyse de données. Cette puissante solution logicielle pour la science des données permet d’exécuter des procédures d’entraînement sur GPU de bout en bout - ce qui réduit la durée de l’entraînement de plusieurs jours à quelques minutes.

LOGICIELS DEEP LEARNING PRÊTS À L’UTILISATION

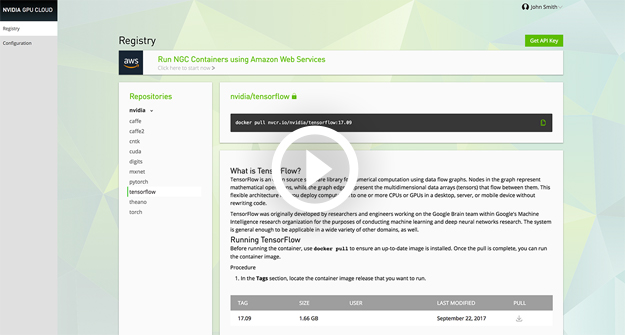

Le registre de conteneurs NGC vous donne accès à un catalogue exhaustif de conteneurs IA accélérés par GPU optimisés, testés et prêts à l’emploi pour une utilisation sur site ou dans le Cloud avec les GPU NVIDIA compatibles. Les conteneurs IA de NVIDIA GPU Cloud, qui incluent les principales solutions logicielles de l’industrie comme TensorFlow, PyTorch, MXNet ou NVIDIA TensorRT™, fournissent un maximum de performance et de polyvalence pour relever les projets les plus ambitieux grâce au potentiel incomparable de l’IA avec NVIDIA. Les chercheurs et les data scientists peuvent ainsi configurer, entraîner et déployer rapidement des modèles IA avancés tout en répondant aux besoins évolutifs des projets Deep Learning de nouvelle génération.

ACCÉLÉRATION GPU DE L’APPRENTISSAGE AUTOMATIQUE ET DE L’ANALYSE DE DONNÉES

TROIS RAISONS DE CHOISIR NVIDIA GPU CLOUD

TECHNOLOGIE DE CONTENEURS DEEP LEARNING À HAUTES PERFORMANCES

Les conteneurs NGC pour l’IA délivrent des performances de pointe mesurées par des benchmarks tels que MLPerf , qui font autorité dans toute l’industrie. Ces résultats sont rendus possibles par notre pile logicielle spécialement optimisée, mais aussi par des années d’innovation sans relâche en matière d’architecture et de systèmes. Tous les utilisateurs peuvent désormais avoir recours à cette même pile logicielle , sur site ou dans le Cloud, grâce aux conteneurs NGC. Chaque mois, les ingénieurs de NVIDIA travaillent en collaboration avec la communauté open-source et contribuent à optimiser une grande variété de projets IA. Ces optimisations sont ensuite mises à votre disposition via un programme de mises à jour pour les principaux conteneurs IA de la plateforme NGC.ACCESSIBLE SUR N’IMPORTE QUELLE PLATEFORME

Notre catalogue de conteneurs logiciels optimisés pour le Deep Learning est accessible gratuitement à tous les utilisateurs sur les plateformes éligibles - qu’il s’agisse de stations de travail fixes, dans le Cloud ou sur Data Center. La conteneurisation garantit une excellente portabilité des projets de Deep Learning à travers de multiples environnements, ce qui permet de réduire les coûts d’exploitation traditionnellement associés aux workflows IA. Les développeurs et les chercheurs qui travaillent en local sur des stations NVIDIA DGX ou sur des PC équipés d’un GPU à architecture NVIDIA Volta ou NVIDIA Pascal, les entreprises qui utilisent des systèmes NVIDIA DGX-1 pour Data Center et les professionnels qui exploitent des GPU NVIDIA dans le Cloud peuvent aujourd’hui accéder à un ensemble d’outils harmonisés et optimisés. Grâce à NGC, les utilisateurs peuvent accélérer la maintenance informatique de manière significative afin d’accroître la productivité, de faire de nouvelles découvertes et d’obtenir des résultats décisifs grâce au Deep Learning.L’INNOVATION POUR TOUTES LES INDUSTRIES

Les ingénieurs et les chercheurs peuvent profiter très rapidement de toute la puissance des technologies IA de NVIDIA grâce à l’architecture GPU la plus puissante au monde et des conteneurs logiciels optimisés pour le Deep Learning. NVIDIA GPU Cloud vous permet d’accomplir des projets d’une grande complexité : accélérer la détection et le traitement des maladies infectieuses, trouver des imperfections dans les infrastructures critiques, développer de nouvelles perspectives commerciales à partir de gros volumes de données, ou bien encore réduire les accidents de la route. De l’l’automobile à la santé en passant par la finance, toutes les industries peuvent profiter des solutions IA de NVIDIA à haut degré d’innovation.

TÉLÉCHARGEZ LA PRÉSENTATION DES SOLUTIONS LOGICIELLES NGC POUR LE DEEP LEARNING

Obtenez plus d’informations sur les principaux frameworks de Deep Learning optimisés par NGC comme TensorFlow, PyTorch, MXnet, Theano, Caffe2 ou Microsoft Cognitive Toolkit (CNTK).

FOIRE AUX QUESTIONS

-

Quels sont les avantages de l’enregistrement à NGC ?

L’enregistrement vous donne accès gratuitement à un catalogue complet de conteneurs logiciels entièrement intégrés et optimisés pour le Deep Learning.

-

Qui peut accéder aux conteneurs sur NGC ?

Les conteneurs sont accessibles à tous les utilisateurs possédant un compte NGC. Le compte permet de télécharger et d’utiliser, sur les plateformes compatibles, les dernières versions de nos conteneurs logiciels spécialement optimisés pour l’accélération GPU.

-

En quoi consistent les conteneurs logiciels pour le Deep Learning ?

Chaque conteneur comprend la solution logicielle NVIDIA GPU Cloud ainsi qu’une pile de logiciels pré-intégrés et optimisés pour le Deep Learning sur les GPU NVIDIA. Les conteneurs incluent par ailleurs un système d’exploitation Linux, l’environnement d’exécution CUDA, les bibliothèques requises et l’application ou le framework sélectionné (TensorFlow, NVCaffe, NVIDIA DIGITS, etc.) - tous conçus pour fonctionner immédiatement et conjointement sans configuration complémentaire.

-

Quels frameworks sont disponibles sur NGC ?

Le registre de conteneurs NGC inclut des versions accélérées par GPU des principaux frameworks de l’industrie : NVCaffe, Caffe2, Microsoft Cognitive Toolkit (CNTK), NVIDIA DIGITS, MXNet, PyTorch, TensorFlow, Theano, Torch, CUDA (pour développeurs).

-

Où exécuter les conteneurs ?

Les conteneurs ont été conçus, testés et certifiés par NVIDIA pour les systèmes de la gamme NVIDIA DGX™, les cartes graphiques NVIDIA TITAN (à architecture NVIDIA Volta et NVIDIA Pascal™), les accélérateurs NVIDIA Quadro GV100, GP100 et P6000, et les GPU NVIDIA dans le Cloud avec Alibaba, Amazon, Google, Microsoft et Oracle.

-

Puis-je exécuter des conteneurs NGC sur mon PC avec une carte graphique GeForce® GTX 1080 Ti ?

Oui. Nos Conditions d’utilisation autorisent l’exécution des conteneurs NGC pour le Deep Learning sur un PC de bureau équipé d’une carte graphique à architecture Volta ou Pascal.

-

Comment puis-je utiliser les conteneurs NGC avec un fournisseur de services Cloud comme Amazon ou Google Cloud ?

Les conteneurs NGC pour le Deep Learning ont été conçus pour être utilisés sur des GPU NVIDIA à architecture Volta ou Pascal™. Les fournisseurs de services Cloud qui figurent au programme NGC fournissent plusieurs types d’instance pour l’exécution des conteneurs NGC. Pour exécuter vos conteneurs, vous devez sélectionner le type d’instance qui vous convient, instancier le fichier-image approprié puis accéder aux conteneurs NGC à partir de cette image. Les étapes de configuration peuvent varier suivant chaque fournisseur de services Cloud. Vous pouvez retrouver les instructions détaillées relatives à chaque fournisseur dans les ressources documentaires de NVIDIA GPU Cloud.

-

Quelle est la fréquence de mise à jour des conteneurs et des frameworks ?

Des mises à jour sont proposées chaque mois. Les conteneurs de Deep Learning sur NGC tirent parti du programme de recherche et de développement mené par NVIDIA en collaboration avec les équipes d’ingénierie de chaque framework, de manière à fournir les meilleures performances possibles. Les ingénieurs de NVIDIA optimisent continuellement l’environnement logiciel avec des mises à jour mensuelles qui garantissent un excellent retour sur investissement.

-

Quelle est l’assistance fournie par NVIDIA ?

Tous les utilisateurs de NGC peuvent accéder aux forums de développement NVIDIA DevTalk https://devtalk.nvidia.com, qui regroupent une vaste communauté d’experts du Deep Learning et du développement GPU (clients, utilisateurs, partenaires et collaborateurs de NVIDIA).

-

Pourquoi NVIDIA fournit ces conteneurs ?

NVIDIA cherche à accélérer l’avènement des technologies IA en fournissant aux chercheurs et aux développeurs un accès simplifié à des frameworks de Deep Learning accélérés par GPU et optimisés pour une utilisation en local ou dans le Cloud avec des GPU NVIDIA.

-

L’accès aux conteneurs est gratuit, mais les ressources de calcul le sont-elles ?

L’accès au registre de conteneurs NGC, entièrement gratuit, est soumis au respect de nos Conditions d’utilisation. Chaque fournisseur de services Cloud propose cependant une tarification spécifique pour ses solutions de calcul accéléré.