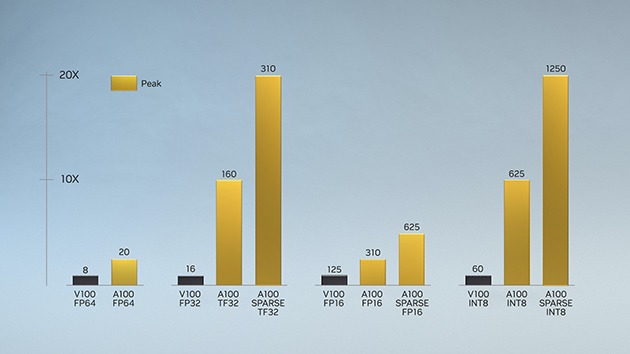

Inizialmente introdotta nell'architettura NVIDIA Volta™, la tecnologia NVIDIA Tensor Core ha generato accelerazioni significative nell'IA, riducendo i tempi di training da settimane a ore e garantendo massima accelerazione per l'inferenza. L'architettura NVIDIA Ampere si basa su queste innovazioni e aggiunge nuove precisioni, Tensor Float 32 (TF32) e virgola mobile a 64 (FP64), per accelerare e semplificare l'adozione dell'IA ed espandere la potenza dei Tensor Core all'HPC.

La precisione TF32 funziona esattamente come la FP32 con velocità fino a 20 volte superiori per l'IA senza alcuna variazione del codice. Con NVIDIA Automatic Mixed Precision, i ricercatori possono raddoppiare le prestazioni grazie alla precisione mista automatica e alla precisione FP16 aggiungendo solo poche righe di codice. Inoltre, grazie al supporto per bfloat16, INT8 e INT4, i Tensor Core nelle GPU Tensor Core basate su architettura NVIDIA Ampere creano un acceleratore incredibilmente versatile per il training e l'inferenza su IA. Portando la potenza dei Tensor Core nell'HPC, le GPU A100 e A30 consentono anche l'esecuzione di operazioni in matrice complete, con conformi allo standard IEEE e con precisione FP64.