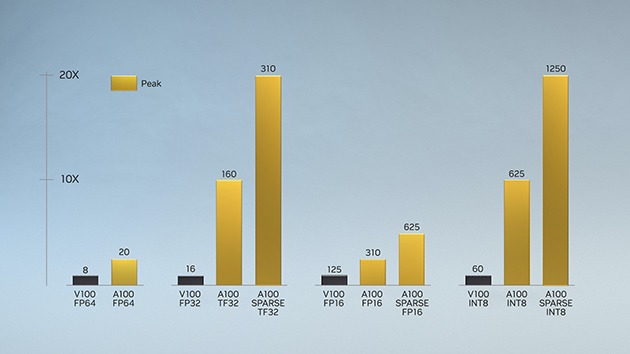

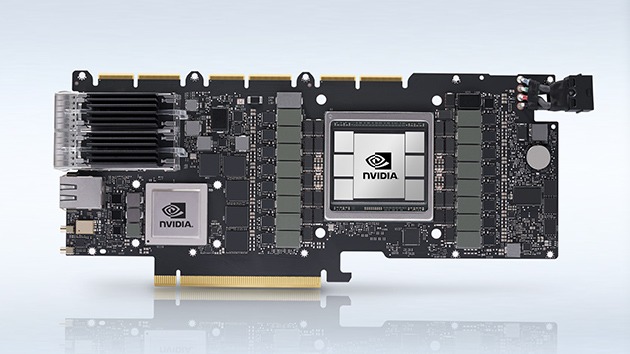

540 億個のトランジスタを搭載した NVIDIA Ampere アーキテクチャは、これまでに製造されてきた中で最大の 7 ナノメートル (nm) チップであり、主に 6 つの画期的な技術革新を特徴としています。

NVIDIA Ampere

アーキテクチャ

世界最高クラスのパフォーマンスを誇るエラスティックなデータ センターの心臓部。