ResNet-50トレーニング、データセット: ImageNet2012、BS = 256 | NVIDIA V100 の比較構成: NVIDIA DGX-2™ サーバー、1x V100 SXM3-32GB、MXNet 1.5.1、コンテナー = 19.11-py3、混合精度、スループット: 1,525 画像/秒 | Intel の比較構成: Supermicro SYS-1029GQ-TRT、1 ソケット Intel Gold 6240@2GHz/3.9Hz Turbo、Tensorflow 0.18、FP32 (この精度のみ利用可能)、スループット: 48 画像/秒

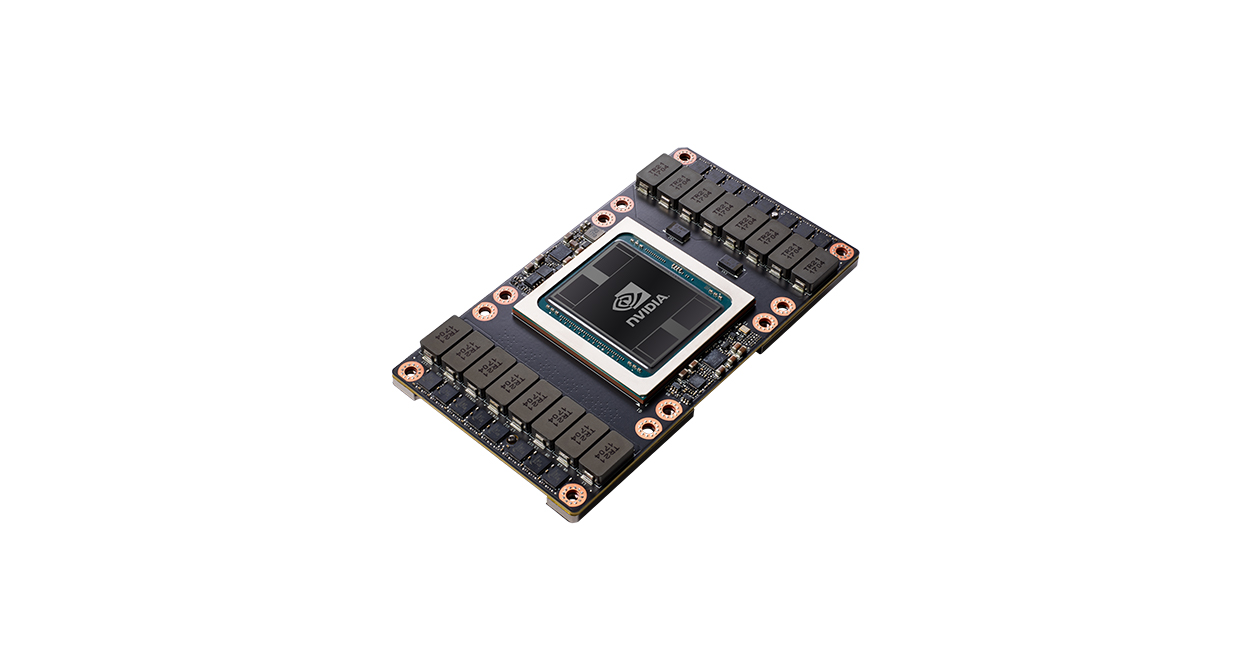

NVIDIA V100

初の Tensor コア GPU