NVIDIA Home

NVIDIA Home

Close

Close icon

Close

Close icon

Close

Close icon

Caret down icon

Accordion is closed, click to open.

Caret down icon

Accordion is closed, click to open.

Caret up icon

Accordion is open, click to close.

Caret right icon

Click to expand

Caret right icon

Click to expand

Caret right icon

Click to expand menu.

Caret left icon

Click to collapse menu.

Caret left icon

Click to collapse menu.

Caret left icon

Click to collapse menu.

Shopping Cart

Click to see cart items

Search icon

Click to search

Visit your regional NVIDIA website for local content, pricing, and where to buy partners

specific to your country.

Argentina

Australia

België (Belgium)

Belgique (Belgium)

Brasil (Brazil)

Canada

Česká Republika (Czech Republic)

Chile

Colombia

Danmark (Denmark)

Deutschland (Germany)

España (Spain)

France

India

Israel

Italia (Italy)

México (Mexico)

Middle East

Nederland (Netherlands)

Norge (Norway)

Österreich (Austria)

Peru

Polska (Poland)

Rest of Europe

România (Romania)

Singapore

Suomi (Finland)

Sverige (Sweden)

Türkiye (Turkey)

United Kingdom

United States

СНГ (CIS)

한국 (Korea)

中国 (Mainland China)

台灣 (Taiwan)

日本 (Japan)

AI 対応のアプリケーションとサービスで画期的なパフォーマンスを実現します。

AI 推論とは、学習済みの AI モデルをデプロイして新しいデータを生成し、AI が結果を提供するよう導くプロセスです。これにより、あらゆる業界でイノベーションを推進します。AI モデルは、規模、複雑さ、多様性の点で急速に拡大し、可能性の限界を押し広げています。企業が AI 推論をうまく活用するためには、エンドツーエンドの AI ライフサイクルをサポートするフルスタックのアプローチと、各チームの目標達成を可能にするツールが必要です。

本番環境に生成 AI をデプロイ

本番環境に生成 AI をデプロイしたり規模を拡大したりする場合に、考慮しなければならない重要なポイントについて、AI 推論の重要な役割を含めて詳しくご覧ください。

推論を高速化するための NVIDIA AI の利点について知る

あらゆるアプリケーション、AI フレームワーク、モデル アーキテクチャ、プラットフォーム間で、モデルのデプロイを標準化します。

パブリック クラウド、オンプレミス データ センター、エッジで、ツールやプラットフォームと簡単に統合できます。

AI インフラストラクチャから優れたスループットと稼働率を実現し、コストを削減します。

生成 AI 推論への最短の道

NVIDIA NIM は、クラウド、データ センター、ワークステーションにまたがって、高性能な AI モデル推論を安全かつ確実にデプロイするように設計された、使いやすいマイクロサービスです。

すべての AI ワークロードに対応する統合型の推論

NVIDIA Triton Inference Server は、オープンソースの推論サービング ソフトウェアです。企業がカスタマイズされた AI モデルのサービング インフラを統合し、新たな AI モデルを本番環境に展開する時間を短縮するのに役立ち、AI 推論と予測能力を高めます。

推論とランタイムを最適化する SDK

NVIDIA TensorRT には、推論ランタイムとモデル最適化が含まれており、本番環境アプリケーションに低遅延と高スループットを提供します。TensorRT エコシステムには、TensorRT、TensorRT-LLM、TensorRT Model Optimizer、TensorRT Cloud が含まれます。

NVIDIA で高速化したインフラストラクチャ 向けに最適化された NVIDIA AI 推論ソフトウェアを使用すれば、比類のない AI パフォーマンスが手に入ります。NVIDIA Blackwell、H200、L40S、NVIDIA RTX™ テクノロジは、データ センター、クラウド、ワークステーション全体にわたって AI 推論ワークロードに優れたスピードと効率を提供します。

NVIDIA Blackwell プラットフォーム

NVIDIA Blackwell アーキテクチャは、生成 AI とアクセラレーテッド コンピューティングの次の発展を特徴づけるものであり、比類のないパフォーマンス、効率性、拡張性を備えています。 Blackwell は、データ処理、電子設計自動化、コンピュータ支援エンジニアリング、量子コンピューティングにおいて画期的な進歩をもたらす 6 つの変革的なテクノロジを備えています。

NVIDIA H200 Tensor コア GPU

NVIDIA H200 Tensor コア GPU は、市場を一変させるパフォーマンスとメモリ機能で生成 AI と高パフォーマンス コンピューティング (HPC) ワークロードを強化します。H200 は HBM3e を搭載した初の GPU であり、この大容量かつ高速なメモリが、HPC ワークロードで科学計算処理を進化させる一方で、生成 AI と大規模言語モデル (LLM) を大幅に高速化します。

NVIDIA L40S GPU

NVIDIA の推論サービング ソフトウェアのフルスタックと L40S GPU を組み合わせることで、推論用にトレーニングされたモデルに適した強力なプラットフォームが実現します。構造化されたスパース性と幅広い精度をサポートする L40S は、NVIDIA A100 Tensor コア GPU の最大 1.7 倍の推論性能を発揮します。

NVIDIA RTX テクノロジ

NVIDIA RTX テクノロジは、ビジュアル コンピューティングに AI をもたらし、タスクを自動化して計算負荷の高いプロセスを最適化することで創造性を高速化します。CUDA® コアの強力な機能により、RTX はリアルタイムのレンダリング、AI、グラフィックス、コンピューティング性能を向上させます。

NVIDIA Project DIGITS の登場

NVIDIA Project DIGITS は、Grace Blackwell のパワーを開発者のデスクトップにもたらします。GB10 Superchip と 128GB の統合システム メモリを組み合わせることで、AI 研究者、データ サイエンティスト、学生は、最大 2,000 億のパラメーターの AI モデルをローカルで実行することができます。

NVIDIA AI がさまざまな業界でどのように活用されているのかをご覧ください。厳選された使用事例を参考にして AI 開発をぜひ開始してください。

デジタル ヒューマン

コンテンツの生成

生体分子の生成

不正検知

AI チャットボット

セキュリティの脆弱性分析

NVIDIA ACE は、開発者がデジタル ヒューマンに命を吹き込むのに役立つテクノロジーのスートです。その中の複数の ACE マイクロサービスは NVIDIA NIM であり、NVIDIA RTX AI PC や 100 カ国に低遅延のデジタル ヒューマン処理を提供する GPU のグローバル ネットワークである NVIDIA Graphics Delivery Network (GDN) で動作するように最適化された、デプロイが容易な高パフォーマンス マイクロサービスです。

生成 AI を使用して、企業のその分野に関する専門知識と独自の IP に基づいて、関連性の高い、カスタマイズされた正確なコンテンツを生成することができます。

生体分子生成モデルと GPU の計算能力により、化学分野を効率的に探索し、特定の創薬標的や特性に合わせた小分子の多様なセットを迅速に生成します。

金融機関は、なりすまし犯罪、口座の乗っ取り、マネーロンダリングなどの高度な不正行為を検知して防止する必要があります。AI 対応のアプリケーションは、取引詐欺の検出における誤検知を低減し、顧客確認 (KYC) 要件における本人確認の精度を向上させ、マネーロンダリング (AML) 対策をより効果的に行い、顧客体験と企業の経営状態の両方を改善します。

企業は、検索拡張生成 (RAG) を使用して、より高性能な AI チャットボットを構築しようとしています。RAG を使用することで、チャットボットは企業のナレッジ ベースから情報を取得し、自然言語でリアルタイムの応答を提供することで、ドメイン固有の質問に正確に回答することができます。こうしたチャットボットは、顧客サポートの強化、AI アバターのパーソナライズ、企業知識の管理、業務の簡略化、高度な IT サポートの提供、コンテンツの作成などに使用できます。

共通脆弱性識別子 (CVE) のデータベースに報告されるセキュリティ上の欠陥件数が 2022 年に過去最高を記録するなどセキュリティ問題が増大する中、ソフトウェアのセキュリティ問題へのパッチ適用は、ますます困難になっています。生成 AI を使用することで、セキュリティ チームの負担を軽減しながら脆弱性に対する防御を改善することができます。

業界のリーダーが AI 推論でイノベーションを推進している方法

Amdocs

生成 AI の性能を高速化し、コストを削減

Amdocs が amAIz を構築するまでの過程をご覧ください、amAIz は通信業者向けのドメイン固有の生成 AI プラットフォームであり、NVIDIA DGX™ Cloud と NVIDIA NIM 推論マイクロサービスを使用することで、遅延を改善し、正確性を大きく向上させ、コストを削減します。

Snapchat

衣料品購買を AI で強化

Snapchat が、Triton Inference Server を使用することで、どのようにして衣料品のショッピング体験と絵文字を認識する光学文字認識を強化し、規模の拡大、コスト削減、本番環境までの時間短縮を実現したのかをご覧ください。

Amazon

顧客満足度の向上

Amazon が TensorRT を使用することで、どのようにして推論を 5 倍に高速化し顧客満足度を改善したのかをご覧ください。

March 11, 2025

今年はあらゆる業界の企業が、AI サービスを展開しています。Microsoft、Oracle、Perplexity、Snap、その他の数百社に及ぶ大手企業にとっては、世界トップクラスの半導体、システム、ソフトウェアで構成

続きを読む

The post 高速かつ低コストの推論が、収益性の高い AI の鍵となる appeared first on NVIDIA | Japan Blog.

February 28, 2025

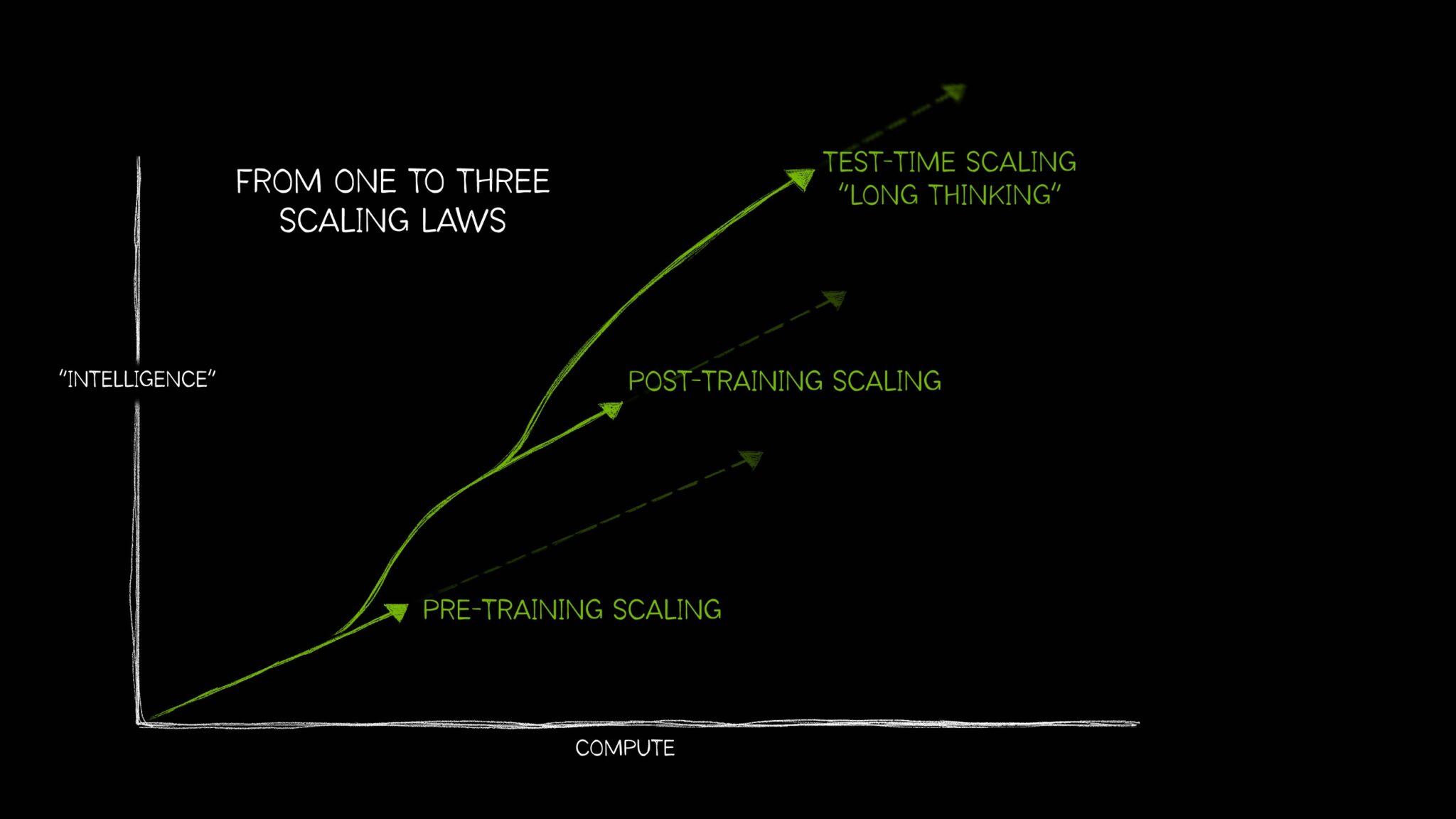

一般に広く理解されている自然界の経験則で、たとえば、「上がったものは必ず下りてくる」、「すべての作用は等しい逆向きの反作用を生む」といったものがあるように、AI の分野でも長い間、単一の考え方が主流を占めてきました。すな

続きを読む

The post よりスマートで強力な AI をスケーリング則によって実現する方法 appeared first on NVIDIA | Japan Blog.

November 13, 2024

製薬会社、医療技術会社、学術研究者が医薬品の発見、ゲノム科学の加速、医療機器の推進を目的としたソブリン AI 機能を開発中 65 歳以上の高齢者が人口の 30% を占める日本は、質の高い医療を提供するために、医療のほぼす

続きを読む

The post 日本が次世代の医薬品設計、ヘルスケア ロボット、デジタル ヘルス プラットフォームを開発 appeared first on NVIDIA | Japan Blog.

さらに読み込む

NVIDIA LaunchPad で推論を始める

現在進行中の AI プロジェクトはありますか?皆さんの AI ソリューションをテストし、プロトタイピングすることができる実践的な経験にぜひお申し込みください。

生成 AI と LLM ラーニング パスを見る

当社の包括的なラーニング パスを使用して、生成 AI や大規模言語モデルの技術スキルを向上させましょう。

NVIDIA LaunchPad での生成 AI 推論を始める

NVIDIA NIM 推論マイクロサービスと AI モデルに今すぐ無料で短期間アクセスし、生成 AI への取り組みを迅速化しませんか。

生成 AI を NVIDIA NIM で本番環境にデプロイ

NVIDIA NIM は生成 AI の可能性を引き出します。この動画では、NVIDIA NIM マイクロサービスがどのようにして、AI のデプロイを本番環境に対応したパワフルなソリューションへと変貌させるのかについて詳しく確認します。

Triton が推論をシンプルにする 5 つの理由

Triton Inference Server は、本番環境への大規模な AI モデルの展開を簡素化します。オープンソースの推論サービス ソフトウェアを使用することで、チームはあらゆる GPU または CPU ベースのインフラストラクチャ上でも、ローカル ストレージまたはクラウド プラットフォームの任意のフレームワークからトレーニング済みの AI モデルをデプロイできます。

NVIDIA が NIM を発表

NVIDIA の NIM 技術で何ができるのか疑問に思ったことはありませんか?驚異的なデジタル ヒューマンやロボットの世界について深く掘り下げながら、NIM で何が可能なのか詳しく見ていきます。

最新のドキュメント、チュートリアル、技術ブログなど、AI アプリケーション開発を始めるために必要な情報をすべてご覧ください。

NVIDIA から最新ニュース、アップデートなどの情報をお送りします。

さっそく始めませんか?

最新のドキュメント、チュートリアル、技術ブログなど、AI アプリケーション開発を始めるために必要な情報をすべてご覧ください。

NVIDIA AI の最新情報

NVIDIA から最新ニュース、アップデートなどの情報をお送りします。

Deploying Generative AI in Production

Optimizing and Scaling LLMs With TensorRT-LLM for Text …

AI Inference in Action: Success Stories and Best …

Deploying, Optimizing, and Benchmarking Large …

Optimize Generative AI inference with Quantization …

Deep Dive into Training and Inferencing Large …

Optimizing Inference Performance and …

Universal Model Serving via Triton and TensorRT

A Temporal Fusion Framework for Efficient Autoregressive …

Scaling AI Inference on the Edge (Presented by …

Scaling Generative AI Features to Millions of …

Accelerating End-to-End Large Language Models …

Optimizing Inference Model Serving for Highest …

Simplifying OCR Serving with Triton Inference Server

Inference at the Edge: Building a Global, Scalable …

Unlocking AI Model Performance: Exploring …

Move Enterprise AI Use Cases From Development to …