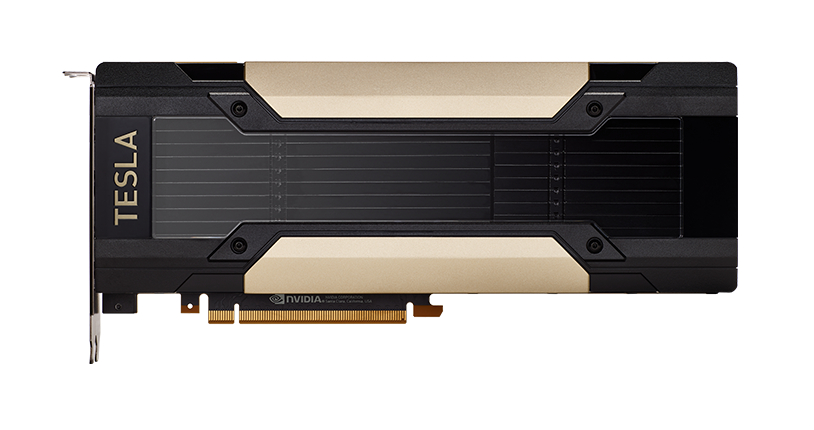

NVIDIA® T4 GPU は、ハイ パフォーマンス コンピューティング、ディープラーニングのトレーニングと推論、機械学習、データ分析、グラフィックスなど、さまざまなクラウド ワークロードを加速します。NVIDIA の新しい Turing™ アーキテクチャを基盤とし、エネルギー効率に優れた 70 ワットの小型 PCIe フォーム ファクターに収納された T4 は、スケールアウト サーバーのスケールアウト コンピューティング環境向けに最適化されています。さらに、多精度の Turing Tensor コアと新しい RT コアを備え、NVIDIA GPU Cloud のコンテナー化された高速ソフトウェア スタックと組み合わせることで、T4 は規模に応じた革新的パフォーマンスを提供します。

ユーザー エンゲージメントの強化を促進

ディープラーニング推論ワークロードにおけるスループットと応答性を向上させます

AI には、爆発的に増加し続けるデータに対応しながら、応答の速さを維持することが求められています。世界最速で最も効率的なデータ センター推論プラットフォームの NVIDIA TensorRT™,が動作する NVIDIA® Tesla® GPU の力でさらなる壁を乗り越えましょう。Tesla はディープラーニングのあらゆるワークロードに対処し、最速のスループット、最高の効率性、最高の柔軟性を組み合わせた最適な推論ソリューションで AI に力を与えます。TensorRT は、Tesla GPU のパフォーマンスを解放し、ビデオストリーミング、音声認識、レコメンダー システムなど、様々なアプリケーションをホストする NVIDIA DeepStream SDK および NVIDIA 推論サーバー製品の基礎を提供します。

NVIDIA データ センター推論プラットフォーム

NVIDIA データ センター コンピューティング ソフトウェア

NVIDIA TensorRT

NVIDIA TensorRT は高パフォーマンスのニューラル ネットワーク推論アクセラレータで、レコメンダー、音声認識、機械翻訳などのアプリケーションを、CPU と比較して 100 倍加速することができます。TensorRT により、開発者はニューラル ネットワーク モデルの最適化、高レベルな精度向上、エンタープライズおよびハイパースケール データ センターの実稼働環境でのモデル展開が可能になります。

DeepStream SDK

Tesla 用 NVIDIA DeepStream は、ディープラーニングをベースとしたスケーラブルなインテリジェント ビデオ分析 (IVA) アプリケーション向け SDK で、スマート シティやハイパースケール データ センターで利用可能です。また、推論用 NVIDIA TensorRT、コード変換用 Video Codec SDK、事前処理機能、データ キュレーション API も利用可能で、Tesla GPU の性能を活用することができます。例えば、Tesla P4 GPU では、最大 30 個の HD ビデオ ストリームのデコードと分析をリアルタイムで同時に行うことができます。

NVIDIA 推論サーバー

NVIDIA 推論サーバーにより、GPU を活用した推論を Kubernetes に導入できます。これはコンテナー化された推論マイクロサービスで、アプリケーションがデータ センターの生産で AI モデルを使用することができるようになります。GPU 使用率を最大化する設計で、一般的な AI モデルやフレームワークをサポートしており、DevOps アーキテクチャへのシームレスな統合が可能です。

NVIDIA GPU 使用の Kubernetes

NVIDIA GPU 使用の Kubernetes により、企業はトレーニングと推論展開をマルチクラウドの GPU クラスターへシームレスに拡大できます。Kubernetes を利用することで、GPU を活用したディープラーニングや HPC (ハイ パフォーマンス コンピューティング) アプリケーションをマルチクラウド GPU クラスターに簡単に展開できます。

特長と利点

50 倍のスループットにより、増加するワークロードに対応

NVIDIA Volta™ を採用した Tesla V100 GPU により、データ センターは劇的に増加したスループットでディープラーニングのワークロードに対応し、大量に押し寄せるデータから情報を抽出できます。Tesla V100 を 1 つ備えたサーバーは、ディープラーニングの推論作業負荷において、CPU だけのサーバー 50 台に匹敵するため、低い購入コストでスループットを劇的に向上させることができます。

低電力スケールアウト サーバーのかつてない効率性

極めて効率性の高い Tesla P4 GPU は、そのスモール フォーム ファクターと 50/75 ワット (W) の電力設計で、高密度に最適化されたスケールアウト サーバーを高速化します。CPU と比較して 52 倍という驚異的なエネルギー効率性でディープラーニングの推論ワークロードに対応します。お客様は既存のインフラストラクチャで機能を拡張し、AI ベースのアプリケーションに対する需要の増加に対応できます。

新しい AI ベースのビデオ サービス向けの専用デコード エンジン

Tesla P4 GPU は最大 39 件の HD ビデオ ストリームをリアルタイムで分析できます。専用のハードウェアで加速するデコード エンジンを備え、NVIDIA CUDA® コアと並列実行され、推論します。ディープラーニングをパイプラインに統合することにより、お客様はビデオ検索やその他のビデオ関連サービスを促進するスマートで革新的な新しいレベルの機能を提供できます。

NVIDIA TensorRT と DeepStream SDK による高速展開

NVIDIA TensorRT は、高性能のニューラル ネットワーク推論アクセラレータで、レコメンダー システム、音声認識、機械翻訳などのディープラーニング アプリケーションの本稼働展開が可能です。TensorRT により、32 ビットまたは 16 ビット データでトレーニング済みのニューラル ネットを、Tesla P4 の低精度 INT8 演算や Tesla V100 の FP16 向けに最適化できます。 NVIDIA DeepStream SDK は Tesla GPU の性能を利用し、ビデオ ストリームのデコードと分析を同時に行います。

GPU 使用率を最大化し、一般的なフレームワークすべてをサポートする推論サーバー

NVIDIA 推論サーバーで、現在のソリューションの性能改善が簡単になり、GPU を最大限活用することができます。NVIDIA 推論サーバーは、すぐに利用可能なコンテナーで提供されるマイクロサービスです。TensorFlow、MXNet、Caffe2、MATLAB、NVIDIA TensorRT、ONNX 規格をサポートするフレームワークのどのモデルの組み合わせにも対応する、シンプルな REST (Representational State Transfer) API 経由で推論を実行できます。

パフォーマンス仕様

| Tesla T4: 世界最先端レベルの推論アクセラレータ | Tesla V100: 汎用性を備えたデータセンター GPU | Tesla P4:超高効率スケールアウト サーバー向け | Tesla P40:推論スループット サーバー向け | |

|---|---|---|---|---|

| 単精度演算性能 (FP32) | 8.1 テラフロップス | 14 テラフロップス (PCIe) 15.7 テラフロップス (SXM2) |

5.5 テラフロップス | 12 テラフロップス |

| 半精度演算性能 (FP16) | 65 FP16 テラフロップス | 112 テラフロップス (PCIe) 125 テラフロップス (SXM2) |

— | — |

| 整数演算 (INT8) | 130 INT8 TOPS | — | 22 TOPS* | 47 TOPS* |

| GPU メモリ | 16GB | 16 GB HBM2 | 8 GB | 24 GB |

| メモリ帯域幅 | 320GB/s | 900 GB/s | 192 GB/s | 346 GB/s |

| システム インターフェイス/フォーム ファクター | ロープロファイル PCI Express フォーム ファクター | デュアルスロット、フルハイト PCI Express フォーム ファクター SXM2/NVLink | ロープロファイル PCI Express フォーム ファクター | デュアルスロット、フルハイト PCI Express フォーム ファクター |

| 電力 | 75 W | 250 W (PCIe) 300 W (SXM2) |

50 W/75 W | 250 W |

| ハードウェアアクセラレーションを使用したビデオ エンジン | 1x デコード エンジン、2x エンコード エンジン | — | 1x デコード エンジン、2x エンコード エンジン | 1x デコード エンジン、2x エンコード エンジン |

*ブースト クロック有効時の Tera-Operations per Second

お客様の事例

あなたのディープラーニング推論ソリューションを今すぐ最適化

ディープラーニング推論向け Tesla V100、T4、P40 発売中。