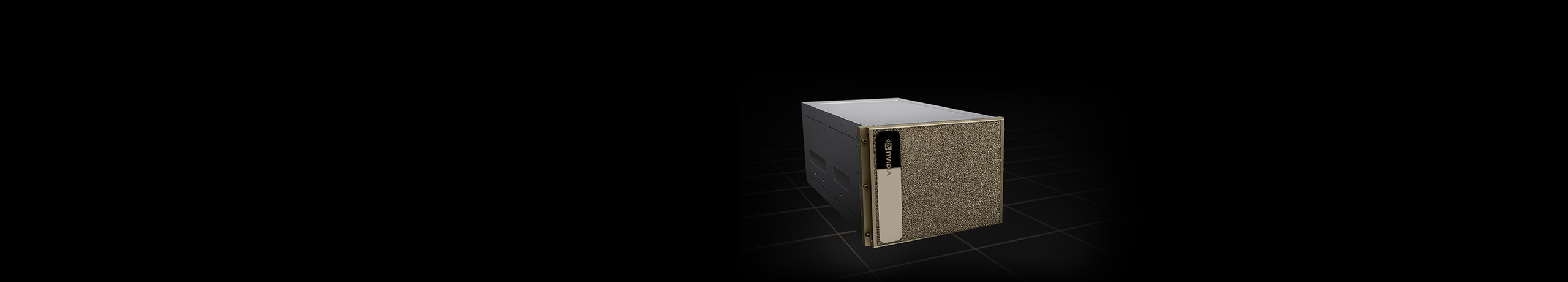

NVIDIA DGX H200

AI 팩토리 인프라의 최적 표준.

세계적으로 입증된 엔터프라이즈 AI 팩토리

NVIDIA DGX™ H200으로 비즈니스 혁신과 최적화의 지평을 넓혀보세요. DGX 플랫폼의 일부인 DGX H200은 NVIDIA DGX SuperPOD™ 및 DGX BasePOD™의 기반이 되는 AI 강자로, NVIDIA H200 Tensor 코어 GPU의 획기적인 성능으로 가속화되었습니다.

가장 완성된 AI 플랫폼

우수한 AI 센터의 기반

NVIDIA Base Command™, NVIDIA AI Enterprise 소프트웨어 제품군, NVIDIA DGXperts의 전문가 지원을 포함하는 완전 통합 하드웨어 및 소프트웨어 솔루션인 DGX H200을 기반으로 우수한 AI 센터를 구축하세요.

나만의 맞춤형 AI 인프라

온프레미스, 동시 위치, 관리형 서비스 제공업체에서의 대여 등 비즈니스에 적합한 다양한 방법으로 DGX H200의 성능을 경험하세요. 또한 DGX-Ready Lifecycle Management를 통해, 조직은 예측 가능한 재무 모델을 확보하여 최첨단 배포를 유지할 수 있습니다.

NVIDIA DGX H200 살펴보기

- 총 1,128GB의 GPU 메모리를 갖춘 NVIDIA H200 GPU 8개

GPU당 NVIDIA NVLink® 연결 18개, 900GB/s의 양방향 GPU 간 대역폭

- NVIDIA NVSwitches™ 4개

이전 세대보다 1.5배 더 많은 7.2TB/s의 양방향 GPU-to-GPU 대역폭 제공

- NVIDIA ConnectX®-7 10개 400Gb/s 네트워크 인터페이스

최대 1TB/s의 양방향 네트워크 대역폭

- 듀얼 인텔 제온 플래티넘 8480C 프로세서, 총 112개 코어, 2TB 시스템 메모리

가장 집약적인 AI 작업을 위한 강력한 CPU

- 30TB NVMe SSD

최고의 성능을 위한 고속 스토리지

NVIDIA DGX에 대한 고객의 의견

- 인용문 1

- 인용문 2

NVIDIA DGX 제품 및 솔루션

사양

NVIDIA DGX H200

| GPU | 8x NVIDIA H200 Tensor Core GPUs |

| GPU Memory | 1,128GB total |

| Performance | 32petaFLOPS FP8 |

| NVIDIA NVSwitch | 4x |

| System Power Usage | ~10.2kW max |

| CPU | Dual Intel® Xeon® Platinum 8480C Processors 112 cores total, 2.00GHz (Base), 3.80GHz (max boost) |

| System Memory | 2TB |

| Networking | 4x OSFP ports serving 8x single-port NVIDIA ConnectX-7 VPI Up to 400Gb/s NVIDIA InfiniBand/Ethernet |

| Management Network | 10Gb/s onboard NIC with RJ45 100Gb/s Ethernet optional NIC Host baseboard management controller (BMC) with RJ45 |

| Storage | OS: 2x 1.9TB NVMe M.2 Internal storage: 8x 3.84TB NVMe U.2 |

| Software | NVIDIA AI Enterprise – Optimized AI software NVIDIA Base Command – Orchestration, scheduling, and cluster management NVIDIA DGX OS / Ubuntu / Red Hat Enterprise Linux / Rocky – Operating system |

| System Weight | 287.6lb (130.45kgs) |

| System Dimensions | Height: 14.0in (356mm) Width: 19.0in (482.2mm) Length: 35.3in (897.1mm) |

| Operating Temperature | 5–30°C (41–86°F) |

DGX H200에 대해 자세히 알아보기

시작하기

다음 단계로 나아가세요

NVIDIA DGX H200 구매하기

조직이 DGX 플랫폼을 어떻게 배포할 수 있는지 알아보세요.

NVIDIA DGX 플랫폼 살펴보기

최고의 NVIDIA 소프트웨어, 인프라 및 전문성을 최신 통합 AI 개발 솔루션에 결합합니다.

NVIDIA DGX 시스템 문서

대규모 생성형 AI 워크로드를 위한 세계적 수준의 성능을 제공하는 DGX 시스템에 대한 문서를 확인하세요.