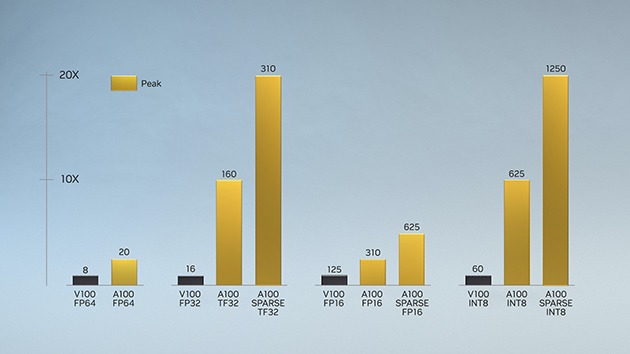

Introduzida pela primeira vez na arquitetura NVIDIA Volta™, a tecnologia NVIDIA Tensor Core trouxe acelerações significativas à AI, reduzindo o tempo de treinamento de semanas para horas e fornecendo aceleração massiva para inferência. A arquitetura NVIDIA Ampere se baseia nessas inovações, trazendo novas precisões, Tensor Float 32 (TF32) e ponto flutuante 64 (FP64), para acelerar e simplificar a adoção da AI e estender o poder dos Tensor Cores para HPC.

O TF32 funciona exatamente como o FP32, ao mesmo tempo que oferece acelerações de até 20 vezes para AI sem exigir nenhuma alteração de código. Usando o NVIDIA Automatic Mixed Precision, os pesquisadores podem obter um desempenho 2 vezes adicional com precisão mista automática e FP16 adicionando apenas algumas linhas de código. E com suporte para bfloat16, INT8 e INT4, Tensor Cores na arquitetura NVIDIA Ampere GPUs Tensor Core criam um acelerador incrivelmente versátil para treinamento de AI e inferência. Trazendo o poder dos Tensor Cores para as GPUs HPC, A100 e A30, também permite operações de matriz com precisão FP64 com certificação IEEE completa.