Aprendizado por Reforço

Técnica de aprendizado de robôs para desenvolver aplicações robóticas adaptáveis e eficientes.

Nissan

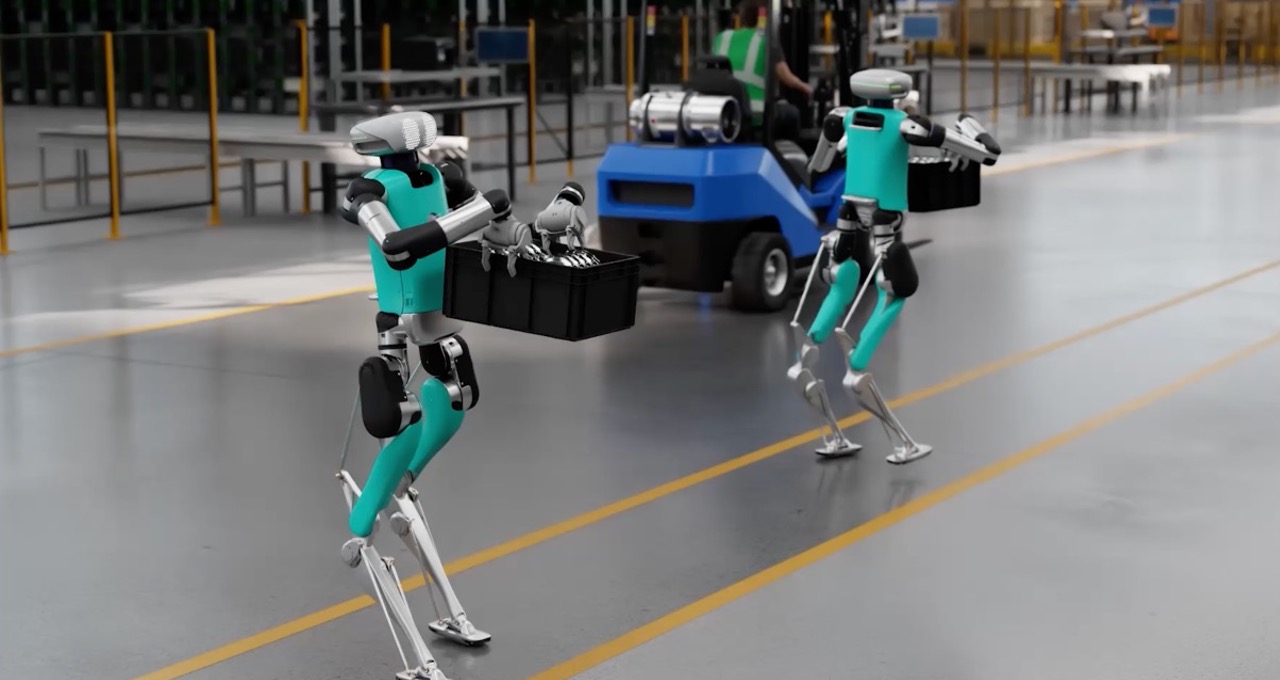

Image Credit: Agility, Apptronik, Fourier Intelligence, Unitree

Cargas de Trabalho

Robótica

Robótica

Todos os setores

Objetivo de Negócios

Inovação

Produtos

NVIDIA Omniverse

NVIDIA Omniverse Enterprise

NVIDIA AI Enterprise

-

Visão Geral

-

Implementação Técnica

-

Ecossistema de Parceiros

Capacite Robôs Físicos com Habilidades Complexas Usando Aprendizado por Reforço

À medida que os robôs assumem tarefas mais complexas, os métodos tradicionais de programação tornam-se insuficientes. O aprendizado por reforço (RL) é uma técnica de machine learning projetada para enfrentar esse desafio programando o comportamento do robô. Com RL em simulação, os robôs podem treinar em qualquer ambiente virtual por tentativa e erro, aprimorando suas habilidades em controle, planejamento de caminhos, manipulação e muito mais.

O modelo RL é recompensado pelas ações desejadas, por isso está constantemente se adaptando e melhorando. Isso ajuda os robôs a desenvolver habilidades motoras grossas e finas sofisticadas necessárias para tarefas de automação do mundo real, como agarrar novos objetos, andar quadrúpede e aprender habilidades complexas de manipulação.

Ao refinar continuamente as políticas de controle com base em recompensas e analisar suas ações, a RL também pode ajudar os robôs a se ajustarem a novas situações e desafios imprevistos, tornando-os mais adaptáveis para tarefas do mundo real.

Treinamento de RL Acelerado por GPU para Robótica

O treinamento tradicional baseado em CPU para RL de robôs pode ser caro, muitas vezes exigindo milhares de núcleos para tarefas complexas que aumentam os custos para as empresas de robôs. As GPUs NVIDIA enfrentam esse desafio com seus recursos de processamento paralelo, acelerando significativamente o treinamento do modelo RL em comparação com as CPUs.

As plataformas de computação da NVIDIA, incluindo ferramentas como o Isaac Lab, aproveitam o poder da GPU para simulações de física e cálculos de recompensa dentro do pipeline de RL. Isso elimina gargalos e agiliza o processo, facilitando uma transição mais suave da simulação para a implantação no mundo real.

Quick Links