更快速、更準確的人工智慧推論

運用人工智慧應用程式和服務,提升突破性效能。

運用人工智慧於推論,進而推動各行各業的創新發展。隨著正快速擴展的 AI 模型,其大小、複雜性和多樣性更加推動可能性的界線。為成功使用 AI 推論,組織和 MLOps 工程師需要一種全棧方法,支援端到端的 AI 生命周期,進而幫助團隊實現目標。

使用 NVIDIA 人工智慧推論平台部署新一代人工智慧應用程式

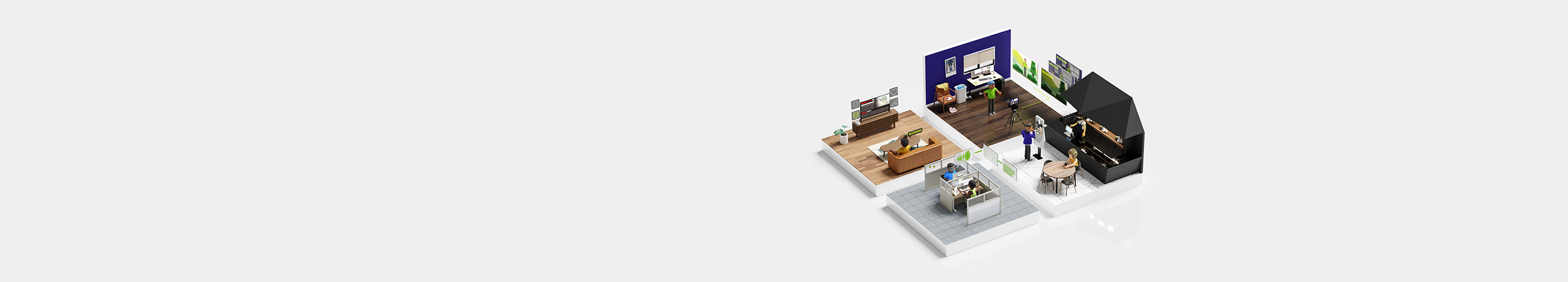

NVIDIA 提供端到端的產品、基礎設施和服務,無論是在雲端、資料中心、網路邊緣,抑或是嵌入式設備中等各種環境,皆支援新一代 AI 推論效能、效率和反應。這些解決方案針對不同程度 AI 專業知識和經驗值的 MLOps 工程師、資料科學家、應用程式開發人員和軟體基礎設施工程師而設計。

NVIDIA 的全棧架構方法可確保 AI 相關的應用程式可以最佳效能、更少的伺服器和更低的功耗進行部署,從而以極低的成本獲得更優異的洞察能力。

NVIDIA AI Enterprise 是一個企業級推論平台,包括頂尖推論軟體、值得信賴的管理、安全性和 API 穩定性,以確保效能及穩定度。

探索優勢

端到端 NVIDIA AI 推論平台

NVIDIA 人工智慧推論軟體

NVIDIA AI Enterprise 由 NVIDIA NIM、NVIDIA Triton™ 推論伺服器、NVIDIA® TensorRT™ 和其他工具組成,可簡化人工智慧應用程式的建構、分享和部署流程。企業可透過企業級支援、穩定性、可管理性和安全性,加速價值實現時間,同時減少意外停機時間。

NVIDIA 人工智慧推論基礎架構

一窺各產業的人工智慧推論

更多資源

隨時掌握 NVIDIA 的最新 AI 推論訊息。